时间序列回归模型--潘登同学的计量经济学笔记

时间序列数据

核心理解: 时间序列数据是一个标有时间序列下标的随机变量序列,也就是随机过程

当我们搜集到一个时间序列数据时,我们便得到该随机过程的一个可能结果或实现, 我们只能看到一个实现,因为我们不能让时间倒转重新开始这个过程。如果特定的历史条件有所不同,我们通常会得到这个随机过程的另一种不同实现,这就是随机过程的含义。

时间序列回归模型

静态模型(static model)

$$ y_t = \beta_0 + \beta_1 x_t + u_t $$ ‘静态模型’源于在设定模型时,$y$与$z$同期的事实。若认为$z$在时间$t$的一个变化对$y$有直接影响,$\triangle y_t = \beta_1 \triangle x_t$,就可以假设一个静态模型...

有限分布滞后项模型(finite distributed lag model)

$$ y_t = \alpha_0 + \delta_0 z_t + \delta_1 z_{t-1} + \delta_2 z_{t-2} + u_t $$

冲击倾向

这是一个二阶的FDL,为了理解系数的作用,举个栗子

| $\ldots$ | $t-2$ | $t-1$ | $t$ | $t+1$ | $t+2$ | $\ldots$ | |

|---|---|---|---|---|---|---|---|

| z | c | c | c | $c+1$ | c | c | c |

那么根据模型,可以写出下式(假设误差为0) $$ y_{t-1} = \alpha_0 + \delta_0 c + \delta_1 c + \delta_2 c \ y_{t} = \alpha_0 + \delta_0 (c+1) + \delta_1 c + \delta_2 c \ y_{t+1} = \alpha_0 + \delta_0 c + \delta_1 (c+1) + \delta_2 c \ y_{t+2} = \alpha_0 + \delta_0 c + \delta_1 c + \delta_2 (c+1) \ y_{t+3} = \alpha_0 + \delta_0 c + \delta_1 c + \delta_2 c \ $$

根据前两个方程,得到$y_t-y_{t-1}=\delta_0$,表明$\delta_0$是$z$在$t$时期提高一个单位所引起$y$的即期变化,$\delta_0$通常被称作冲击倾向(impact propensity)或冲击乘数(impact multiplier).

类似地,$\delta_1 = y_{t+1} - y_{t-1}$这个是即期变化发生后,下一期$y$的变化,$\delta_2 = y_{t+2} - y_{t-1}$这个是,而在$t+3$期,$y$回到了初始水平,这是因为我们只假定了$z$中只有两期滞后。

如果将$\delta_j$作为$j$的函数作图,变得到滞后分布(lag distribution)

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-P6VvUxWR-1649407145508)(滞后分布.png)]

上图意味着,最大的影响发生在第一期滞后;滞后分布的含义是: 如果我们把$y$的初始值标准化为0,这个滞后分布就描绘出$z$暂时提高一个单位所导致$y$的随后所有取值

长期倾向

当$z$永久提高所导致的$y$的变化同样重要,根据模型我们可以写出下式 $$ y_{t-1} = \alpha_0 + \delta_0 c + \delta_1 c + \delta_2 c \ y_{t} = \alpha_0 + \delta_0 (c+1) + \delta_1 c + \delta_2 c \ y_{t+1} = \alpha_0 + \delta_0 (c+1) + \delta_1 (c+1) + \delta_2 c \ y_{t+2} = \alpha_0 + \delta_0 (c+1) + \delta_1 (c+1) + \delta_2 (c+1) \ $$

随着$z$从第$t$期开始永久提高,一期后$y$提高了$\delta_0 + \delta_1$,两期后提高了$\delta_0 + \delta_1 + \delta_2$,两期以后,$y$没有进一步变化。$z$的当期及滞后项系数之和$\delta_0+\delta_1+\delta_2$,等于z的永久性提提高,导致y的长期变化,这被称为长期倾向(long run propensity,LRP)或长期乘数(long-run multiplier)

经典假设下OLS性质

与横截面分析类似, 时间序列回归也要做相关假定, 但假定的内容与横截面回归有些许差异...

TS.1 线性于参数

随机过程${(x_{t1},x_{t2},\ldots,x_{tk},y_i):t=0,1,\ldots,n}$服从线性模型 $$ y_i = \beta_0 + \beta_1 x_{i1} + \ldots + \beta_k x_{ik} + u_t $$ 其中, ${u_t: t=1,2,\ldots,n}$是误差或干扰序列。其中, $n$是观测次数

如果将解释变量$x$视作矩阵$X_{t,j}$,第$t$行表示时刻$t$的横截面数据,第$j$列则表示变量$j$在时间上的变化

TS.2 无完全共线性

在样本中,没有任何自变量是恒定不变的,或者是其它自变量的一个完全的线性组合; 该假定允许解释变量之间相关,但是不允许样本中的完全相关。

TS.3 零条件均值

对每一个$t$,给定所有时期的解释变量,误差项$u_t$的期望值为0 $$ E(u_t|X) = 0 , t=1,2,\ldots,n $$

以横截面分析中的说法,从无关性角度来考虑这个假定最为容易。 这个假定意味着,$t$时期的误差项$u_t$与每个时期的任何解释变量都无关。

回想横截面的零条件均值,其实是TS.3的特例 $$ E(u_t|x_{t1},\ldots,x_{tk}) = E(u_t|X_t) = 0 $$ 这就是在一个时期中,$u_t$与同时期的解释变量无关,此时我们称$x_{tj}$是同期外生的

但TS.3不仅仅要求同期外生性: 即使$s\neq t$,$u_t$也必须与$x_{sj}$无关。此时,我们称解释变量是严格外生的

另外一个重要的方面就是,假定TS.3并没有限制不同时期自变量或$u_t$的相关性,他只是说,$u_t$的平均值与任何事情的解释变量都不相关。

导致TS.3无效的可能原因

导致TS.3无效的两个可能原因主要是: 遗漏变量和对某些回归元的测量误差。

考虑如下模型: $$ y_t = \beta_0 + \beta_1 z_t + u_t $$ 假定TS.3不但要求$u_t和z_t$不相关,而且要求$u_t与z_t$的过去值和将来值都不相关。这有两重含义,

- $z对y$没有滞后影响,如果$z对y$的确有滞后影响,那就应该估计一个分布滞后模型

- 严格外生性排除了误差项的即期变化,导致$z$未来变化的可能性,这就有效排除了$y对z$未来值的反作用

对于上面模型,假如$z_t$表示农民的劳动投入量,$y_t$表示农作物产量,假定$u_t$与过去的劳动投入量都无关; 一旦农民根据上一年劳动投入量来决定今年的劳动投入量,那么$u_t$与$z_{t+1}$可能就不是无关的,因为大的$u_t$导致大的$y_t$进而导致小的$z_{t+1}$,这种变量就可能不是严格外生的

政策变量,如货币供给的增长、福利开支、高速公路的限速等经常受结果变量过去的影响。在社会科学中,很多解释变量都明显违背严格外生性假定

OLS无偏性

在满足TS.1-3,以$X$为条件,OLS估计量是无偏的,并存在 $$ E(\hat{\beta}_j) = {\beta}_j $$

另外两个假定

TS.4 同方差性

以$X$为条件,在所有时期$t,u_t$的方差都相等: $$ Var(u_t|X) = Var(u_t) = \sigma^1, t=1,2,\ldots,n $$

TS.5 无序列相关性

以X为条件,任意两个不同时期的误差都不相关: $$ Corr(u_t,u_s|X) = 0, \forall s\neq t $$

当上式不成立时,就认为误差有序列相关或自相关的问题

OLS的样本方差

在时间序列高斯-马尔科夫假定TS.1到TS.5下,以$X$为条件,$\hat{\beta}_j$的条件为方差 $$ Var(\hat{\beta_j}|X) = \frac{\sigma^2}{SST_j(1-R_j^2)},j=1,2,\ldots,k $$

其中,$SST_j是x_{tj}$的总平方和(固定$j$),$R_j^2$是所有其他自变量回归得到的$R^2$

上式方差基本上与在截面数据推导的方差一致,而且导致方差变大的因素(如多重共线性)都与截面数据的结论一致

方差的无偏估计

在TS.1-TS.5下,估计量$\hat{\sigma^2} = \frac{SSR}{df}$是$\sigma^2$的一个无偏估计量,其中$df=n-k-1$

在TS.1-TS.5下,以$X$为条件,OLS估计量是最优线性无偏估计

经典线性模型假定下的推断

为了能够使用通常的OLS标准误,t统计量和F统计量,我们通常需要增加最后一个假定,他类似于横截面分析中所用的正态性假定

TS.6 正态性

误差$u_t$独立于$X$,且具有独立同分布$N(0,\sigma^2)$

TS.7 正态抽样分布

/在前6个假定下,以$X$为条件,OLS估计量遵循正态分布,而且在原假设下,每个t统计量服从t分布,F统计量服从F分布,通常构造的置信区间也是有效的

趋势

在很多情况下,两个时间序列过程表现出相关性,仅仅是因为,由于某些无法观测的因素的作用,二者具有共同的时间趋势而已。如果忽略两个序列按照相同或者相反趋势延伸的事实,会导致错误的结论:认为一个变量的变化由另一个变量的变化导致。

一个能将统计模型描述有趋势行为的简单模型是 $$ y_t = \alpha_0 + \alpha_1 t + e_t $$ 其中,${e_t}$是一个独立同分布(i.i.d.)的序列,且$E(e_t)=0,Var(e_t)=\sigma_t^2$。上式形成了一个线性时间趋势,当$\triangle e_t = 0$时, $$ \triangle y_t = y_t - y_{t-1} = \alpha_1 $$

若${e_t}$是一个独立同分布序列,则${y_t}$是一个独立(但非同分布)序列。对趋势时间序列更现实的描述是,允许${e_t}$在不同时期相关,但这并没有改变线性时间趋势的本质。

指数趋势

许多经济时间序列都能用指数趋势来近似,当一个序列在每个时期都具有相同的增长率时,他就具有指数趋势。

时间序列的指数趋势可以通过建立有线性趋势的自然对数模型得到($y_t>0$) $$ \log(y_t) = \beta_0 + \beta_1 t + e_t $$ 将两边取指数后,$y_t$便表现出指数趋势: $y_t = \exp(\beta_0 + \beta_1 t +e_t)$

解释$\beta_1$,对于很小的变化$\triangle \log(y_t) = \log(y_t) - \log(y_{t-1})$近似等于$y_t$的变化 $$ \triangle \log(y_t) = \frac{y_t - y_{t-1}}{y_{t-1}} $$ 上式的右边,被称作$y$从$t-1$时期到$t$时期的增长率。 设$\triangle e_t = 0$便得到,对所有的$t$ $$ \triangle \log(y_t) = \beta_1 $$ 也就是说,$\beta_1$近似等于$y_t$每期增长率的平均值。

除了线性和指数趋势,还会有更复杂的时间趋势(如:二次时间趋势)

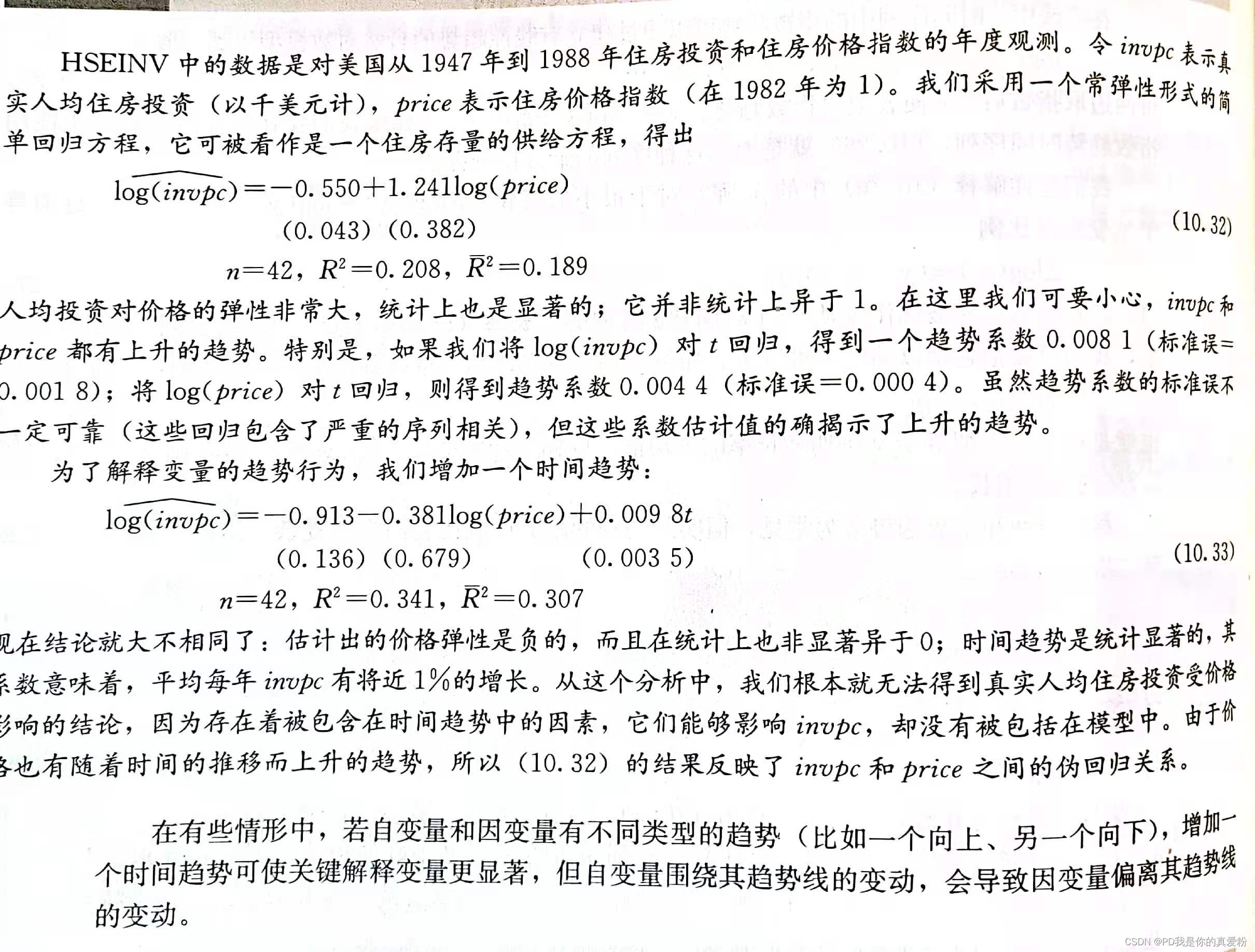

伪回归问题

考虑到某些无法观测的趋势因素影响$y_t$又有可能与解释变量相关, 如果我们的方程中没有加入时间趋势,我们便可能得到$y_t$与一个或多个解释变量之间的伪回归问题,仅仅因为每个变量都随着时间的推移而增长。 而解决的方法很简单,只需要将趋势变量放进方程中即可。

除趋势解释

考虑如下回归方程 $$ \hat{y_t} = \hat{\beta_0} + \hat{\beta_1}x_{t1} + \hat{\beta_2}x_{t2} + \hat{\beta_3}t $$

具体做法如下:

- 将$y_t,x_{t1},x_{t2}$分别对常数项和时间趋势$t$回归,并记录残差$\ddot{y_t},\ddot{x}_{t1},\ddot{x}_{t2}$,如: $$ y_t = \hat{\alpha_0} + \hat{\alpha_1}t + \ddot{y_t} $$

- 将$\ddot{y_t}对\ddot{x}_{t1},\ddot{x}_{t2}$的回归,这个回归得到的碰巧就是原回归方程的$\hat{\beta_1},\hat{\beta_2}$,这说明了原方程的估计值就是除去了时间趋势的解释,即$x_{t1}$变化一单位,$y_t$变化$\hat{\beta_1}$单位

如果某个自变量含有趋势,那么,即使$y_t$不含趋势,在回归中包含趋势项是一个好主意。假若$y_t$没有明显的趋势,但$x_{t1}$可能随时间的推移而上升,那么去掉回归中的趋势变量,即使$x_{t1}$沿着其趋势的变动对$y_t$有影响,看起来也好像$x_{t1}对y_{t}$没有影响。若在回归中包含$t$,便能刻画这种影响。

含趋势的$R^2$

时间序列回归中的$R^2$通常很大,特别是与横截面数据的$R^2$相比。这是因为时间序列总是以总量形式出现,而总量数据通常比个人、企业或家庭的数据更容易解释。 但是当因变量含有趋势时,时间序列回归中的普通或调整$R^2$基本关于人为地变大。 根据调整$R^2$ $$ \bar{R^2} = 1 - \frac{\hat{\sigma^2_u}}{{\hat{\sigma^2_y}}} $$ 其中,$\hat{\sigma^2_u}$是误差方差的无偏估计,$\hat{\sigma_y}^2 = \frac{\sum_{=1}^{n}(y_t - \bar{y})^2}{n-1}$ 在$y_t$含有趋势时,只要回归中包含了时间趋势,$SST/(n-1)$就不再是$Var(y_t)$无偏或一致估计。 $SST/(n-1)$往往高估了$Var(y_t)$,因为他没有解释$y_t$的趋势

一般的做法是,当因变量含有趋势时,先过滤掉时间趋势对$y_t$的影响,将$y_t$对$t$回归,得到残差$\ddot{y_t}$,然后将$\ddot{y_t}对x_{t1},x_{t2},t$进行回归,该回归的$R^2$是 $$ 1 - \frac{SSR}{\sum_{t=1}^n\ddot{y_t}^2} $$ 显然$\sum_{t=1}^n\ddot{y_t}^2 \leq \sum_{t=1}^n(y_t - \bar{y_t})^2$,从而得出$R^2$比原本计算的要小。而这个$R^2$能够很好地反映出$x_{t1}与x_{t2}$能在多大程度上解释$y_t$,因为他过滤掉了时间趋势的影响。

而调整$R^2$为 $$ (1 - \frac{SSR}{\sum_{t=1}^n\ddot{y_t}^2}) \cdot \frac{n-p}{n-k} $$ 其中,$n-k$是主回归方程的自由度(这里是$n-4$),$n-p$是$y_t$对时间趋势回归的自由度(这里是$n-2$)

注意: 虽然除趋势的$R^2$能更加好的刻画解释变量对被解释变量的影响,但是在计算$F$统计量的$R^2$形式的时候,还是用未经除趋势的$R^2$

季节性

如果一个时间序列是每月或每季度观测而得到的,它就有可能表现出季节性。 同时很多月份或季度数据序列都表现出季节性变化,但也并非一律如此(如: 每月利息率或通货膨胀率就没有明显的季节性变化)。 而且,有季节性变化的序列通常在公布执之前就进行了季节调整,已经除掉了其中的季节性因素。 经过季节性调整的序列,拿过来直接用就行。

如果真的需要我们自己处理季节性问题的话,在回归方程中包含总季节-1个虚拟变量就足够了,如(月份=11,季节=3)

除季节性的$\beta$解释、$R^2$都与上面除趋势的操作一致... 列是每月或每季度观测而得到的,它就有可能表现出季节性。 同时很多月份或季度数据序列都表现出季节性变化,但也并非一律如此(如: 每月利息率或通货膨胀率就没有明显的季节性变化)。 而且,有季节性变化的序列通常在公布执之前就进行了季节调整,已经除掉了其中的季节性因素。 经过季节性调整的序列,拿过来直接用就行。

如果真的需要我们自己处理季节性问题的话,在回归方程中包含总季节-1个虚拟变量就足够了,如(月份=11,季节=3)

除季节性的$\beta$解释、$R^2$都与上面除趋势的操作一致...